NVIDIA Tensor Core 的演变:从 Volta 到 Blackwell

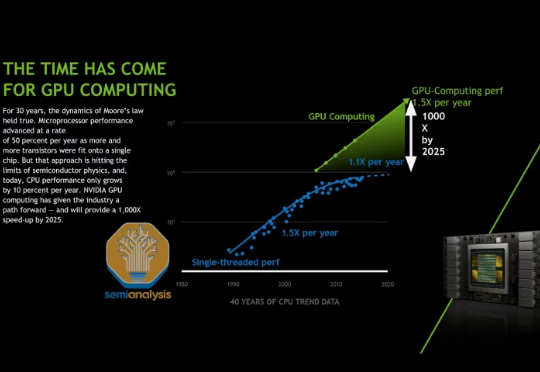

NVIDIA Tensor Core 的演变:从 Volta 到 Blackwell在我们去年 AI Scaling Laws article from late last year中,我们探讨了多层 AI 扩展定律如何持续推动 AI 行业向前发展,使得模型能力的增长速度超过了摩尔定律,并且单位 token 成本也相应地迅速降低。

在我们去年 AI Scaling Laws article from late last year中,我们探讨了多层 AI 扩展定律如何持续推动 AI 行业向前发展,使得模型能力的增长速度超过了摩尔定律,并且单位 token 成本也相应地迅速降低。

CVPR 2025,自动驾驶传来重大进展: Scaling Law,首次在这条赛道被验证!

不去今年的CVPR不知道,原来中国自动驾驶在AI领域的创新已经这么牛了。作为今年唯一受邀参与CVPR演讲的车企,这家公司在AI顶流圈层上桌吃饭了!

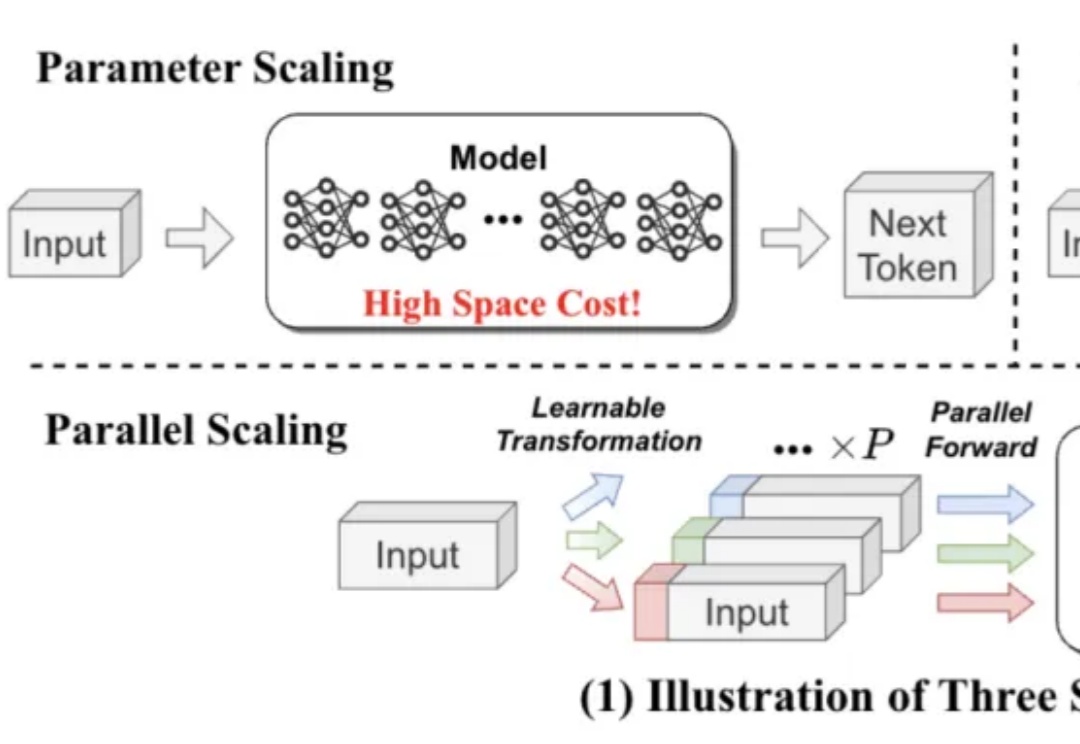

既能提升模型能力,又不显著增加内存和时间成本,LLM第三种Scaling Law被提出了。

2023年,业界还在卷Scaling Law,不断突破参数规模和数据规模时,微软亚洲研究院张丽团队就选择了另一条路径。

「Scaling Law 即将撞墙。」这一论断的一大主要依据是高质量数据不够用了

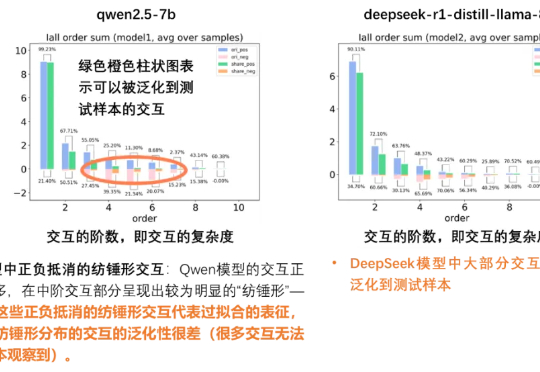

当以端到端黑盒训练为代表的深度学习深陷低效 Scaling Law 而无法自拔时,我们是否可以回到起点重看模型表征本身——究竟什么才是一个人工智能模型的「表征质量」或者「泛化性」?我们真的只有通过海量的测试数据才能抓住泛化性的本质吗?或者说,能否在数学上找到一个定理,直接从表征逻辑复杂度本身就给出一个对模型泛化性的先验的判断呢?

Jim Fan,英伟达机器人部门主管和杰出科学家、GEAR 实验室联合领导人、OpenAI 的首位实习生,最近在红杉资本主办的 AI Ascent 上做了一场 17 分钟的演讲

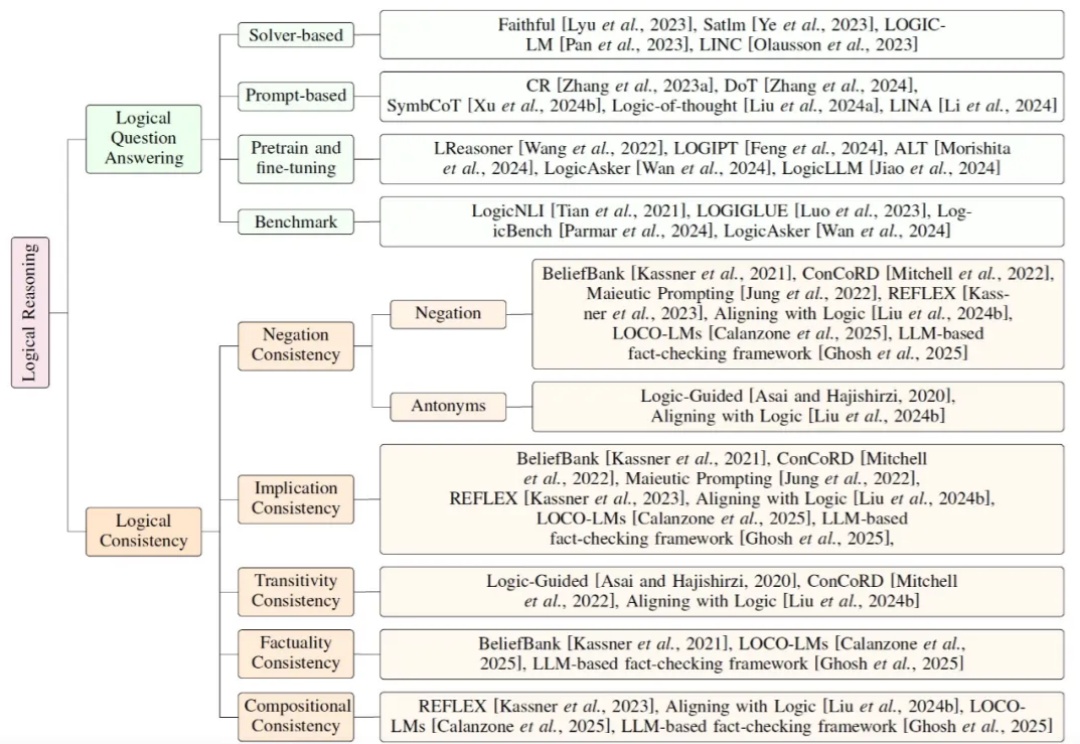

当前大模型研究正逐步从依赖扩展定律(Scaling Law)的预训练,转向聚焦推理能力的后训练。鉴于符号逻辑推理的有效性与普遍性,提升大模型的逻辑推理能力成为解决幻觉问题的关键途径。

研究揭示早融合架构在低计算预算下表现更优,训练效率更高。混合专家(MoE)技术让模型动态适应不同模态,显著提升性能,堪称多模态模型的秘密武器。